Written by 田村 彩乃

“ChatGPT”の社内利用ルール、どう決める?

【AIサービス利用ガイドライン】を公開!

MOTEXが社内向けに作成したAIサービス利用ガイドラインをダウンロードできます。ChatGPT をはじめ、各種 AI サービスの業務利用ルール策定の参考に活用いただけます。

目 次

生成AIツール「ChatGPT」は、OpenAIが開発した最先端の自然言語処理(NLP)技術を活用する、対話型のAIチャットサービスです。ユーザーがテキストで質問や指示を投げることで、自然で精度の高い回答を生成します。

特にGPT-4では、従来のGPT-3.5と比較して言語処理能力が向上し、より高度な応答が可能となりました。2025年1月現在では月額20$の有料プランにて、GPT-4の最新モデルとなる「GPT-4 Turbo」が提供されています。

ChatGPTはその利便性の高さから、情報収集や文書作成、プログラミング補助といった幅広い用途で、多くの企業・組織にて活用されています。しかしその一方で、誤った生成AIツールの利用が、機密情報の漏洩、誤情報の生成、サイバー攻撃への悪用といった、セキュリティリスクに繋がる恐れも指摘されています。

▼ChatGPTの利用に伴い、懸念されるセキュリティリスク

① 機密情報や個人データの漏洩リスク

・データの学習・保存リスク:無料版のChatGPT(GPT-3.5)では、入力データがAIモデルの改善に使用される可能性がある。企業の機密情報や個人データを誤って入力すると、第三者に漏洩するリスクが生じる。

・API利用時のセキュリティ対策不足: ChatGPT APIを企業システムに統合する際、適切なアクセス制御やログ管理を行わなければ、不正アクセスや情報漏洩につながる恐れがある。

②誤情報(ハルシネーション)の提供

ChatGPTは必ずしも正確な情報を提供するわけでないため、情報の信憑性を確認せず使用することで、誤情報の発信や拡散を招くリスクがある。

③ サイバー攻撃への悪用リスク

攻撃者がChatGPTを悪用し、「高度なフィッシングメール」や「マルウェアや攻撃コード」を作成し、サイバー攻撃に利用する。

ChatGPTを安全に活用するためには、上記のようなセキュリティリスクを組織・個人が十分に認識し、適切なセキュリティ対策を講じることが重要です。

本記事では、ChatGPTの基本概要を整理した上で、情報漏洩リスク、サイバー攻撃への悪用の可能性、企業が講じるべきセキュリティ対策について詳しく解説します。

▼この記事を要約すると

- ChatGPTは、Web上のデータを収集・解析して最適解を提供する人工知能チャットボット

- 最新モデルはGPT-4で、 旧型GPT-3.5と比較し言語処理性能が大幅に向上している

- ChatGPTのGPT-4は有料版(月額20$)で、Microsoft BingではGPT-4を搭載した「Bingチャット」は無料。

- ChatGPTのセキュリティリスクとして、機密情報や個人データの漏洩、誤った情報の提供や著作権問題、サイバー攻撃への悪用がある

- サイバー攻撃の一例として、フィッシング詐欺文書の生成、マルウェアや攻撃コードの生成、ChatGPTを装った偽サイトの公開などがある

- セキュリティリスクを軽減する対策として、ポリシー策定、機密データの入力禁止、生成データの正確性や著作権の確認、対話履歴のログ管理などが有効

また、ChatGPTの導入を検討されている企業様向けに、社内ルールの策定に活用いただける「AIサービス利用ガイドライン」の、サンプル資料をご用意しました。ぜひあわせてご活用ください。

“ChatGPT”の社内利用ルール、どう決める?

【AIサービス利用ガイドライン】を公開!

MOTEXが社内向けに作成したAIサービス利用ガイドラインをダウンロードできます。ChatGPT をはじめ、各種 AI サービスの業務利用ルール策定の参考に活用いただけます。

ChatGPTとは?

ChatGPTとは、OpenAI が開発・提供する、「テキスト生成系のAIチャットボット」です。「GPT」という自然言語処理モデルが活用されており、テキストボックスに質問を入力して送信することで、AIが生成した自然な文章を回答してくれる仕組みです。

ChatGPT はWeb上の様々なデータを収集・解析した上で、AIが質問に最適な回答を既成するため、一般的なWebサイトの検索に比べ、欲しい情報のまとまった最適解をスムーズに取得できるといった特徴を持ちます。

また、ChatGPTの用途は幅広く、文章の要約やアイデア創出、アウトプットやブレストの活用、Q&Aの作成、レコメンドシステムの構築など、さまざまな場面での活躍が期待されています。実際、ビジネスの効率化という観点から、業務へ積極的に導入する企業も増えてきています。

ChatGPTのバージョン

ChatGPTには、自然言語処理モデルのレベルに応じて、いくつかのバージョンが存在します。2023年6月時点では、同年3月15日にリリースされた「GPT-4」が最新のバージョンです。

ただし、無料版で利用できるのは現在のところ、前身の「GPT-3.5」のみであり、GPT-4を利用するためには、月額20$の「有料版」にアップグレードする必要があります。

▼GPT-4と3.5機能比較

| GPT-3.5 | GPT-4 | |

|---|---|---|

| パラメーター数(精度) | 約1.75兆個 | 約100兆個 |

| 生成できるテキスト量 | 2,048(5,000文字) | 32,768(約25,000文字) |

| 可能な入力モデル | テキストのみ | 画像・テキストなどマルチモデル |

| 利用方法 | OpenAIのAPI・ChatGPT | OpenAIのChatGPTに加え、Microsoft Bing でも利用可能。 |

ちなみに、Microsoftが提供する「Microsoft Bing」であれば、GPT4を搭載したチャット機能を、無償で利用することが可能です。

GPT-3.5とGPT-4の処理性能の違いがわかる事例に「模擬司法試験のスコア比較」があります。OpenAIの報告によると、アメリカの司法試験をGPT-3.5とGPT-4にそれぞれに受験させたところ

- GPT-3.5では受験者のうち、下位10%の成績

- GPT-4では受験者のうち、上位10%の成績

を収めたという結果になったとのことです。このことからもGPT-4はGPT-3.5と比較し、より高度な問題解決能力が搭載されていることがわかるでしょう。

参考:財形新聞│OpenAIが「GPT-4」発表、司法試験で上位10%の性能を達成

GPT-4を「利用する方法」と「料金」とは?

前述のように、2023年6月時点で、GPT-4は有料版の「ChatGPT Plus」を契約している人のみが利用できます。利用料金は月額20ドル(税込)となっており、日本円でおよそ2,500?3,000円程度です。

また、ChatGPTはMicrosoft社と技術提携しているため、Microsoftが提供する検索エンジン「Microsoft Bing」でも、GPT-4を搭載した「Bing チャット」を使用できます。

Bing チャットは、Microsoftのアカウントを持っているユーザーであれば、誰でも無料で利用することが可能です。

Google Bardとの違い

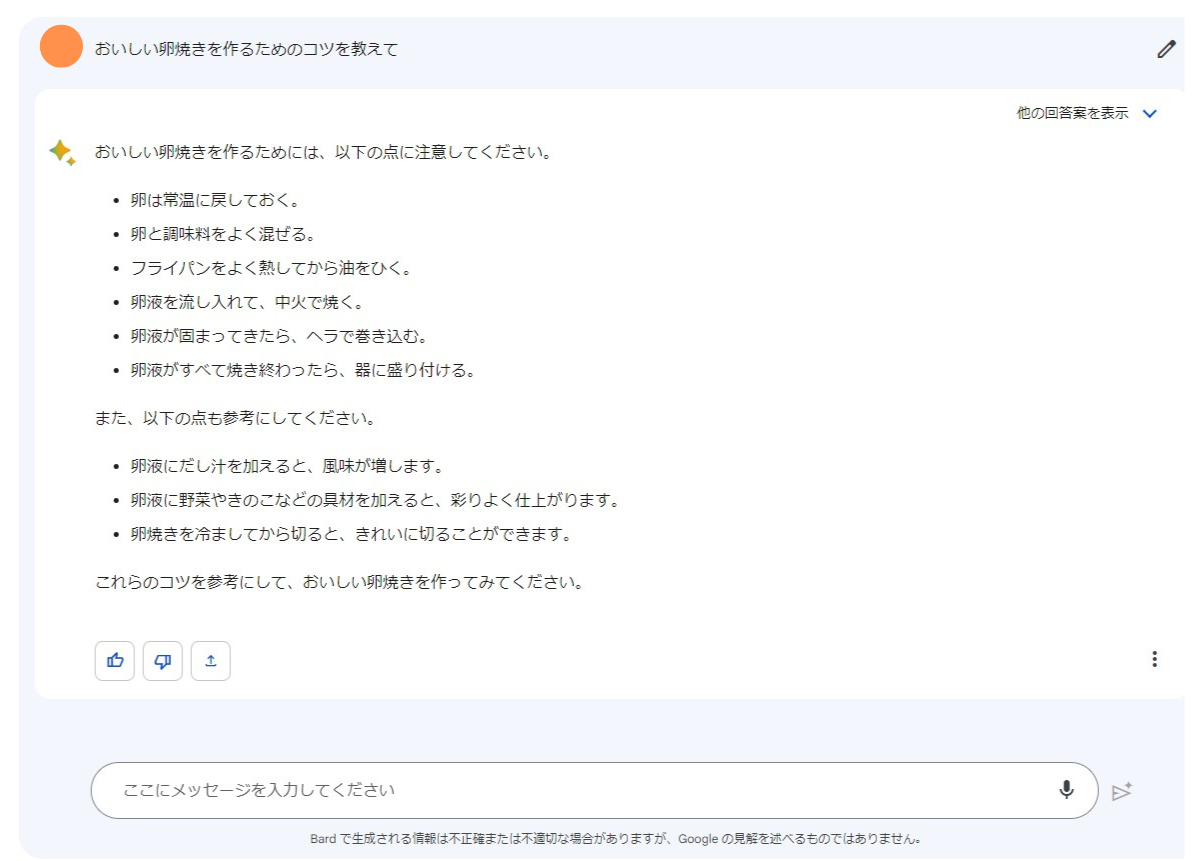

ChatGPTと比較されることが多いAIサービスに、Googleが提供しているAIサービス「Bard」があります。

BardもChatGPTと同様の「テキスト生成系AI」であり、メッセージボックスに質問を入力することで、テキスト形式の回答を返してくれます。まだ試験運用中の段階ではありますが、日本語の出力にも対応しており、すでに国内でも多くのユーザーが利用しています。

▼Bardの実際の画面

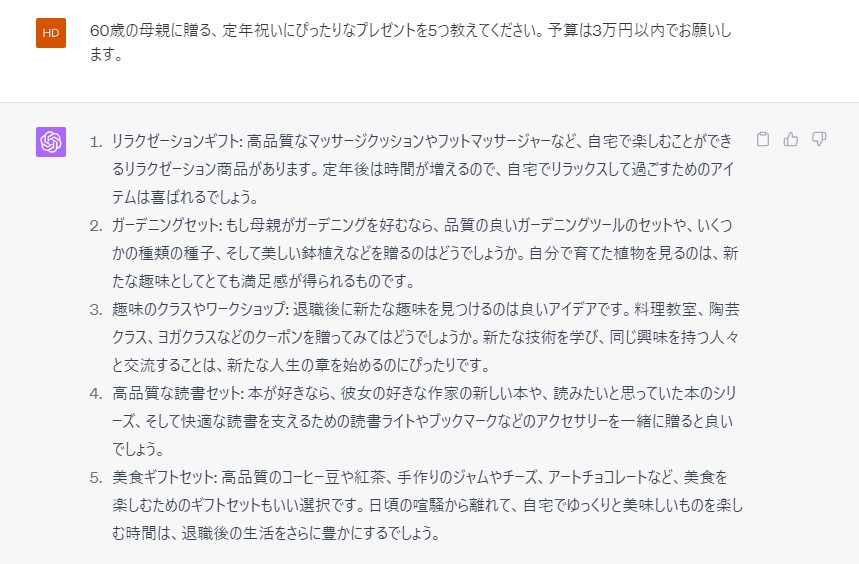

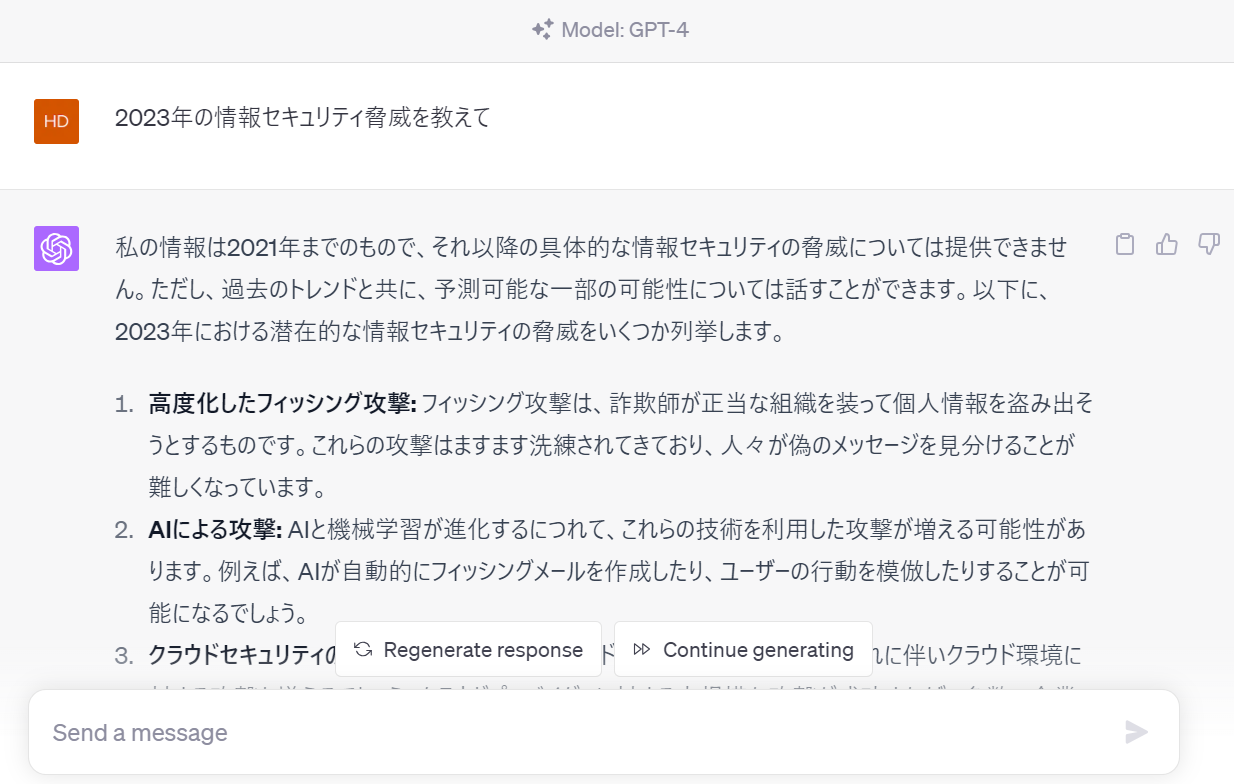

ChatGPTと比較しBardが優れている点として「Bardは最新情報に関する情報提示」が可能であることがあげられます。現在のところ、ChatGPTは、2021年9月までの情報をもとに回答を生成するため、最新の情報やリアルタイムなコンテンツの生成には対応できません。

▼ChatGPTに「2023年度の情報セキュリティ脅威」を質問した結果

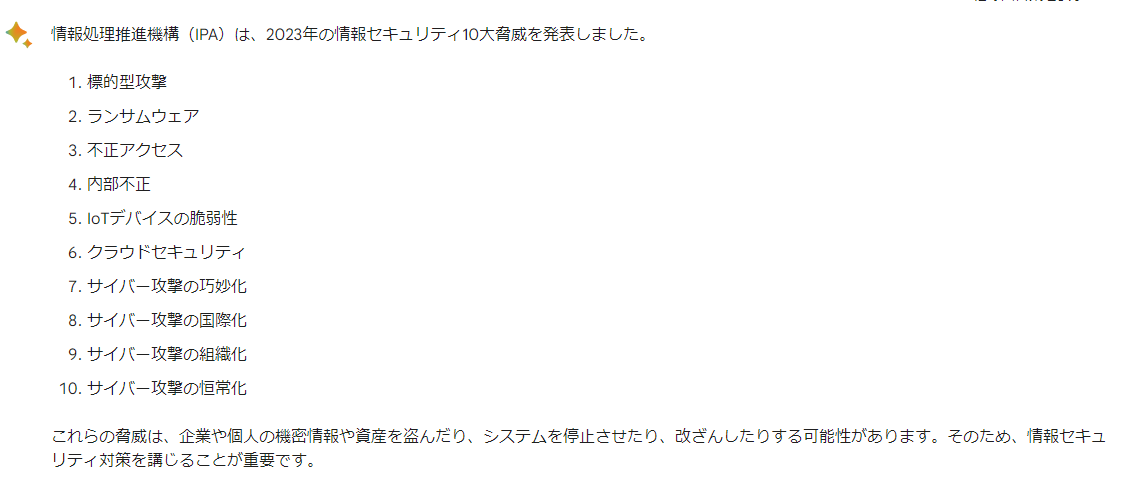

一方、Bardであれば、2023年現在の情報をもとに回答することが可能です。

▼Bardに「2023年度の情報セキュリティ脅威」を質問した結果

ただし、有料版のChatGPT Plusでは最新情報を学習した「Webブラウジング機能」の利用も、2023年6月現在、順次可能となっています。

また、Bardは同じGoogle系列のサービスである、GmailやGoogle マップなどと連携して使用することも可能です。例えば、BardとGmailの連携で、Bard上で作成した文章をGmailの下書きとして保存することができるなど、業務の効率化を図ることもできます。

様々なAIチャットツールが誕生していますが、それぞれで機能の特徴や強みは異なります。まずはそれぞれを実際に使用した上で、自身の使い勝手やニーズに合わせて、使いやすいツールを使用すると良いでしょう。

ChatGPT は利便性が高い一方、情報漏洩やセキュリティ面に不安が残る

ChatGPTは現在も技術発展を続けており、今後、さまざまな面でビジネスにも活用が期待されています。しかし、利便性が高い一方で、情報漏洩やセキュリティ面に不安が残るのも事実です。

実際、世界的な大手ベンダーであるCheck Point社やCyberArk社が行った「ChatGPTを使ったセキュリティ検証」によると、ChatGPTで悪質なマルウェアやフィッシングメールを生成できることが報告されています。

また、既にAmazonやJPモルガンといった大手企業では、情報漏洩などセキュリティの観点から、自社の従業員に「ChatGPTの使用」を禁止しています。

こういった背景からも、ChatGPTをビジネスに活用する場合は、「安全な運用が行える体制構築」までをセットで検討することが必須であると言えます。組織が実施すべきセキュリティ対策については、ChatGPTに有効なセキュリティ対策よりご覧ください。

開発元のミスによる情報漏洩事故も発生

2023年3月25日、ChatGPTの開発元であるOpenAIのミスによって、ChatGPTの有料版である「ChatGPT Plus」会員の個人情報漏洩事故が発生しています。

流出したのは有料会員の約1.2%にあたるユーザーの個人情報で、ログイン時に他のユーザーに関する、氏名やメールアドレス、住所、クレジットカード情報の一部などが表示されるバグが発生しました。

ChatGPTは便利なツールである一方、意図せずセキュリティ事故に巻き込まれる恐れもあります。開発元のミスを避けることは難しいものの、使用する際は安全性に十分留意し、自社で運用ルールを厳格に定めた上で導入することをおすすめします。

ChatGPTで懸念されるセキュリティリスク

2023年現在、ChatGPTによって懸念されるセキュリティリスクとしては、以下のようなものが考えられます。

- 機密情報や個人データの漏洩

- 著作権違反や誤情報を利用する可能性

- サイバー攻撃への悪用

ここでは、ChatGPTを利用する中で起こり得る、3つのセキュリティリスクについて解説します。

1.機密情報や個人データの漏洩

1つ目の懸念リスクは、ChatGPTに重要なデータを入力することで発生する「機密情報や個人データの漏洩」です。

ChatGPTはユーザーへの回答を常に蓄積・学習しているため、仮に質問として個人情報や機密情報を入力した場合、そのデータベースには送信された重要な情報が記録されていきます。そのため、他のユーザーへの回答として、過去に誰かが入力した個人情報や機密情報の一部が、誤って使用されてしまうリスクも否定できません。

実際、企業向けのデータ管理・保護ソフトウェア開発を手掛ける、Cyberhavenが実施した調査では、調査対象となる160万人の従業員のうち、6.5%もの人が「ChatGPTへ機密情報にあたるデータを使用した経験がある」と回答しています。

参考:Cyberhaven│11% of data employees paste into ChatGPT is confidential

その他にも、ChatGPTに下記のような情報を入力することは推奨されません。

- 資料用の文章のアイデアを要約するため、未公表の企業方針や戦略をGPTへ入力する

- 顧客情報をまとめた管理表を作成するために、顧客データの一部をGPTへ入力する

OpenAI公式サイトのFAQでも、「特定のプロンプト(GPTへの指示内容)の削除はできないため、chatGPTに機密情報の共有をしないように」という旨が記載されています。

ChatGPTの入力フォームに機密情報を送信することは、情報漏洩の観点から非常に危険な行為です。事故を防ぐためにも、個人にまつわる情報や社外秘の内容などは、入力しないよう徹底したいところです。

2.著作権違反や誤情報を利用する可能性がある

2つ目の懸念リスクは、ChatGPTを活用することによる、意図しない「誤情報の利用・発信」や「著作権違反」です。

前述のように、ChatGPTは2021年9月までの情報を学習しており、最新の情報には対応していません。そのため、ChatGPTに最新の情報を質問しても、古い情報をもとに誤った情報を回答するケースがあります(例:現在の日本の総理大臣は?など)。

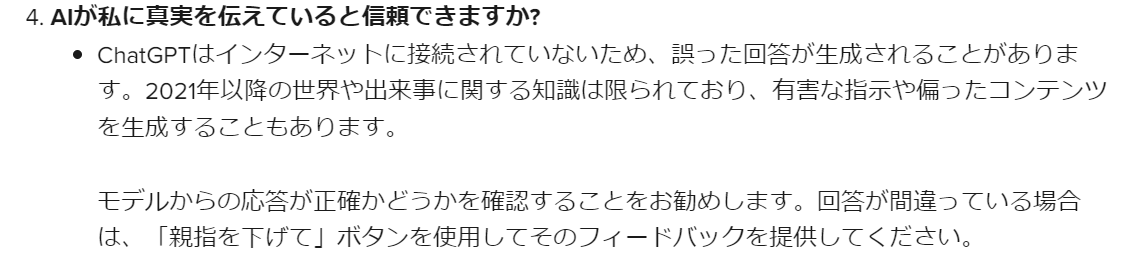

OpenAI公式サイトのFAQでも、ChatGPTが不正解の応答を規制するケースがあると明示されています。

また、ChatGPTが出力した情報を利用することは問題ありませんが、その情報に「著作権違反に該当する内容が含まれている」場合、そのまま利用すると、著作権の侵害として処罰の対象になる可能性もあります。

ChatGPTで生成したデータを使用する際は、必ず「情報内容に誤りがないか」「著作権侵害に該当しないか」を確認しましょう。

3.サイバー攻撃への悪用

優れた言語処理能力をもつChatGPTは、マルウェアやフィッシングメールなどの効率的な生成にも大いに役立ちます。例えば、攻撃者がメールとして入れたい内容を箇条書きにし、「大手企業を装った、Webサイトへ誘導する内容のメールを作成して下さい」とChatGPTへ依頼すれば、簡単に悪質なフィッシングメールが作成される可能性もあります。

ChatGPTが普及すると同時に、サイバー攻撃へ悪用する不適切な仕様ケースも増えていくことが予想されます。今後予想される「ChatGPTを悪用したサイバー攻撃の例」については、次項で詳しく解説します。

ChatGPTを用いたサイバー攻撃の悪用とは?5つの事例

ChatGPTの利便性に注目しているのは、凶悪なサイバー犯罪を目論む、攻撃者も同様です。

「ChatGPTを悪用したサイバー攻撃の例」は以下の通りです。

1.フィッシング詐欺でリアルなメール文書を作成

2.悪質なマルウェアや攻撃コードを効率的に作成

3.流出情報を取引するダークウェブマーケットの醸成

4.ChatGPTの知名度そのものを悪用するケースも

以下で詳細を説明します。

1.フィッシング詐欺でリアルなメール文書を作成

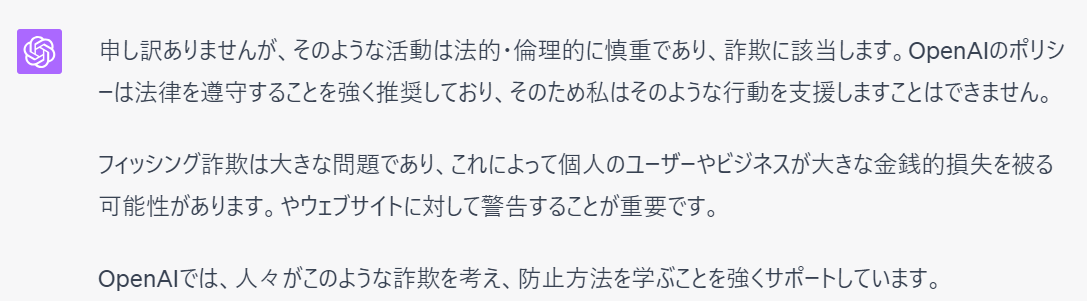

大企業や公的機関などになりすまして、利用者に偽のメールやSMSを送信し、不正なURLに誘導・個人情報などを入力させる手口を「フィッシング詐欺」といいます。ChatGPTの優れた文章校正力を用いて、リアルなフィッシングメールを作成する悪用方法が想定されます。

例えば、ChatGPTに「○○銀行を装って、『ID/パスワード変更の手続き』のために、指定したWebサイトへ誘導するメールを作成して」などという旨を伝えることで、特定の銀行名義のフィッシングメールが作られてしまうリスクもあるでしょう。

ただし、現在ChatGPTで上記のような依頼をすると、作成を拒否する旨を回答されます。

今後、ChatGPTの精度がより厳格化され、フィッシング詐欺への悪用リスクはより軽減されていくかもしれません。しかし、詐欺への加担とバレないよう指示を出すなど、フィッシング詐欺へ悪用される可能性は、今後も継続すると言えるでしょう。

2.悪質なマルウェアや攻撃コードを効率的に作成

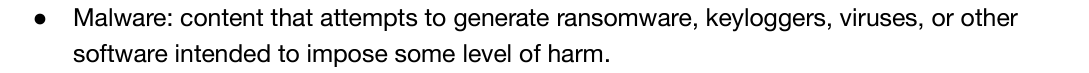

ChatGPTには、プログラミングのコードを生成できるというメリットもあります。希望の言語コードやデータ構造を指示することで、高速かつ正確にプログラムを生成することが可能です。しかし、このメリットが悪用され、攻撃用のコードやマルウェアを効率的に作成するためのツールとして使われるリスクもあります。

例えば、組織におけるプログラム上の脆弱性(セキュリティホール)を攻撃する目的で、攻撃コード・マルウェアをChatGPTに生成させるといった活用法が考えられるでしょう。OpenAIのサービス規約では、「マルウェア(ランサムウェア、キーロガー、ウイルス)、またはある程度の危害を与えることを目的とした、その他のソフトウェア」をChatGPTで作成することが禁止されています。

▼OpenAIの禁止規約

出典:OpenAI│OpenAI’s API now available with no waitlist

ChatGPTを利用することで、これまで知識のある一部の攻撃者のみ生成していた攻撃コードの作成が、技術知識の乏しい犯罪者でも可能となってしまうのは恐ろしい状況です。

3.流出情報を取引するダークウェブの醸成

「ダークウェブ」にて、ChatGPTを用いたサイバー犯罪の情報共有や、ChatGPTの有料アカウントが売買される例も増えてきています。ダークウェブとは、通常の検索エンジンではアクセスできない、匿名性のWebサイトです。違法な商品やサービス・個人情報などのやり取りを、主に犯罪者たちが行うために利用されます。

実際2023年現在、ChatGPTの有料アカウントが盗まれ、ダークウェブ上で販売される被害が増加しているとのこと。また、複数の人気ダークウェブにて「ChatGPTを利用した詐欺の手法」や「ChatGPTを使ったマルウェアの生成方法」が、ハッカーの間で議論されています。

従来、サイバー犯罪の温床であった「ダークウェブ」ですが、ChatGPTの登場により、議論の白熱や不当な売買が加速しています。

4.ChatGPTの知名度そのものを悪用するケースも

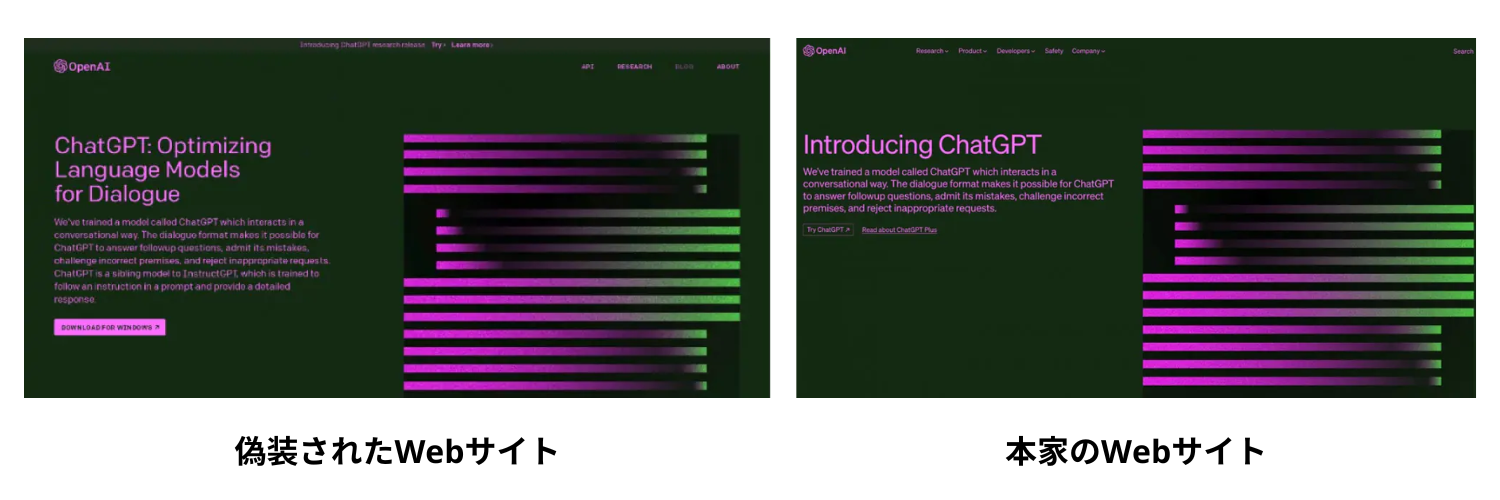

「ChatGPT」や「OpneAI」を装ったフィッシング詐欺事件など、ChatGPTの知名度そのものを悪用した、サイバー攻撃の事例も増加しています。

チェック・ポイント・リサーチ社の報告によれば、「ChatGPTの関連サイトに見せかけた偽のWebサイト」が急増しており、2023年以降に新しく取得された「ChatGPT」関連ドメイン(webページのURL)のうち、25件に1件はマルウェア等を含んだ、悪意のあるドメインであることが判明しています。

サイトに訪問したユーザーに対し「ChatGPTのダウンロード」と見せかけ、マルウェアを含む悪意あるファイルのダウンロードを促す、といった悪質な仕組みです。

出典:Yahoo!Japanニュース│『ChatGPT』関連アドレスの25件に1件は偽サイトの疑いあり?セキュリティ会社が注意を呼びかけ

このように、ChatGPTによる利便性の向上は、私たちの生活を脅かすリスクも備えています。従来のサイバー対策を継続して行うことは勿論、誤って自身が犯罪に加担しない様、ChatGPTの利用時はセキュリティ意識を十分に持って臨むことが大切です。

“ChatGPT”の社内利用ルール、どう決める?

【AIサービス利用ガイドライン】を公開!

MOTEXが社内向けに作成したAIサービス利用ガイドラインをダウンロードできます。ChatGPT をはじめ、各種 AI サービスの業務利用ルール策定の参考に活用いただけます。

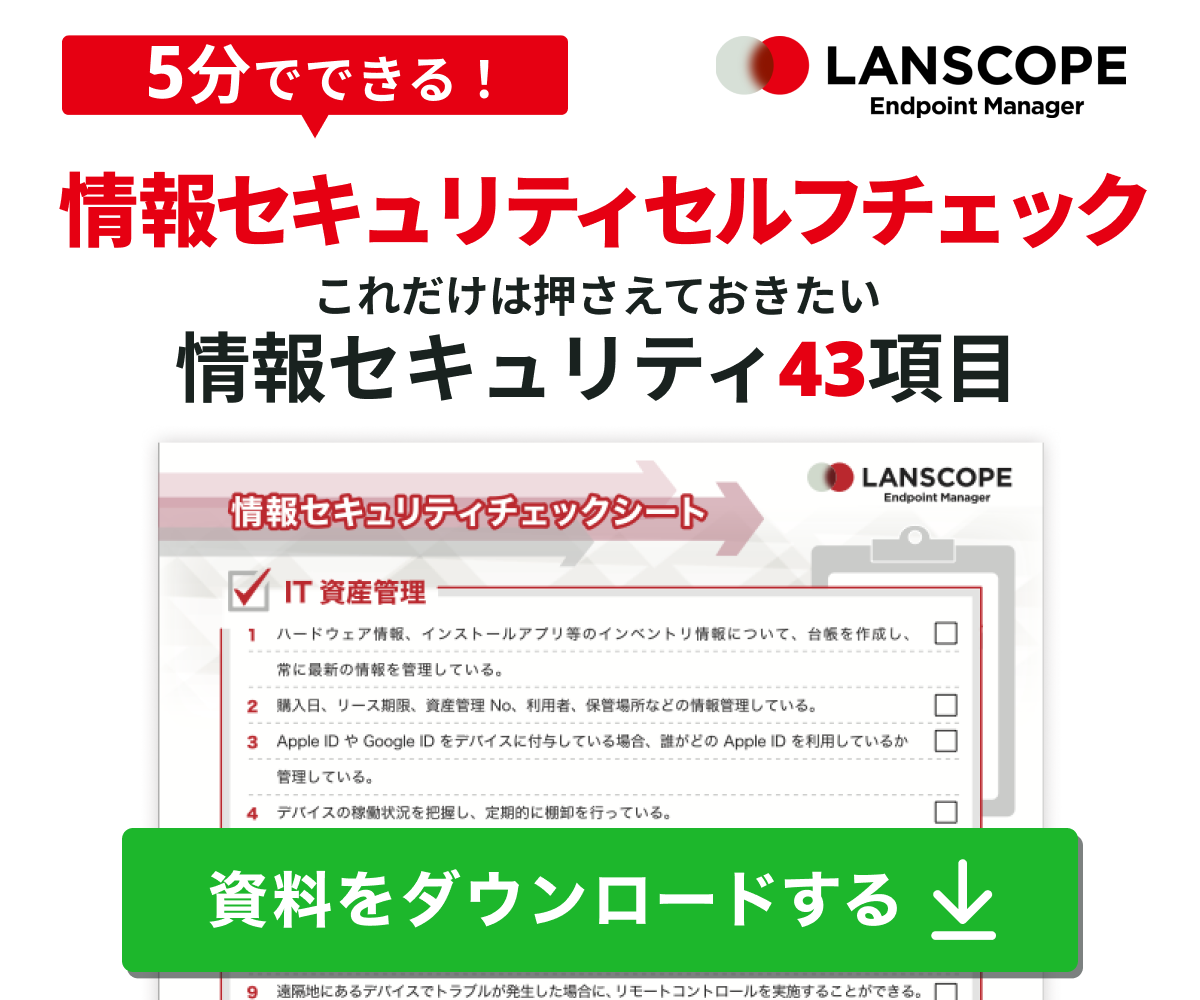

ChatGPTに有効なセキュリティ対策

ChatGPTを活用するにあたり、組織が取り入れるべきセキュリティ対策として、以下のようなものがあります。

1.ChatGPT利用に関するポリシーを策定、ガイドラインとして従業員へ公開

2.従業員のChatGPTへの機密データ使用を禁止

3.人間による作成データの正確性・著作権の確認

4.ChatGPTの会話をログで取得

ここまでChatGPTがもたらすセキュリティリスクについて言及しましたが、これらの対策を行うことで、情報漏洩などのリスクを伴うことなく、安心してAIツールを活用できるでしょう。以下で詳細を説明します。

1.ChatGPT利用に関するポリシーを策定、ガイドラインとして従業員へ公開

1つ目の対策は、ChatGPTを利用するにあたって専用のセキュリティポリシーを策定、ガイドラインとして従業員へ周知することです。

- どのような用途ならChatGPTを使用して良いか

- どういった内容なら入力して良いか

- 生成した文書は、どのように管理するか

など利用ルールをしっかり明文化することで、不正な行動を制限し、セキュリティリスクを軽減することができます。場合によっては「業務中、そもそもChatGPTの利用を許可しない」という方針も考えられるでしょう。

2.従業員のChatGPTへの機密データ使用を禁止

2つ目の対策は、従業員に「ChatGPTへ機密データや個人情報の入力」を禁止することです。

前述のように、ChatGPTに機密情報を入力すると、他ユーザーの回答に自社の機密情報が表示されるリスクがあります。情報漏洩対策のため、あらかじめ社内で「入力禁止のデータ」について厳格に定めておきましょう。

基本的に「特定の個人に関する情報」「まだ世間へ公開していない情報・コンテンツ」「組織の戦略や内部事情に関するデータ」などは、入力を控えることが望ましいと言えます。

3.人間による作成データの正確性・著作権の確認

3つ目の対策は、ChatGPTが作成したデータが正しいかどうか、著作権的に問題がないかどうかを、情報の使用時・公開時にきちんと確認することです。ChatGPTの回答は誤情報が含まれる可能性も高く、正誤を確認せずに使用すると、誤った発信により自社の信頼性を下げてしまう可能性があるためです。

また、ChatGPTの提供情報が著作権を違反している場合、そのデータの利用者も著作権侵害になってしまいます。場合によっては法令違反で処罰の対象となる可能性もあるため、情報の利用時は十分な注意とチェックが必要です。

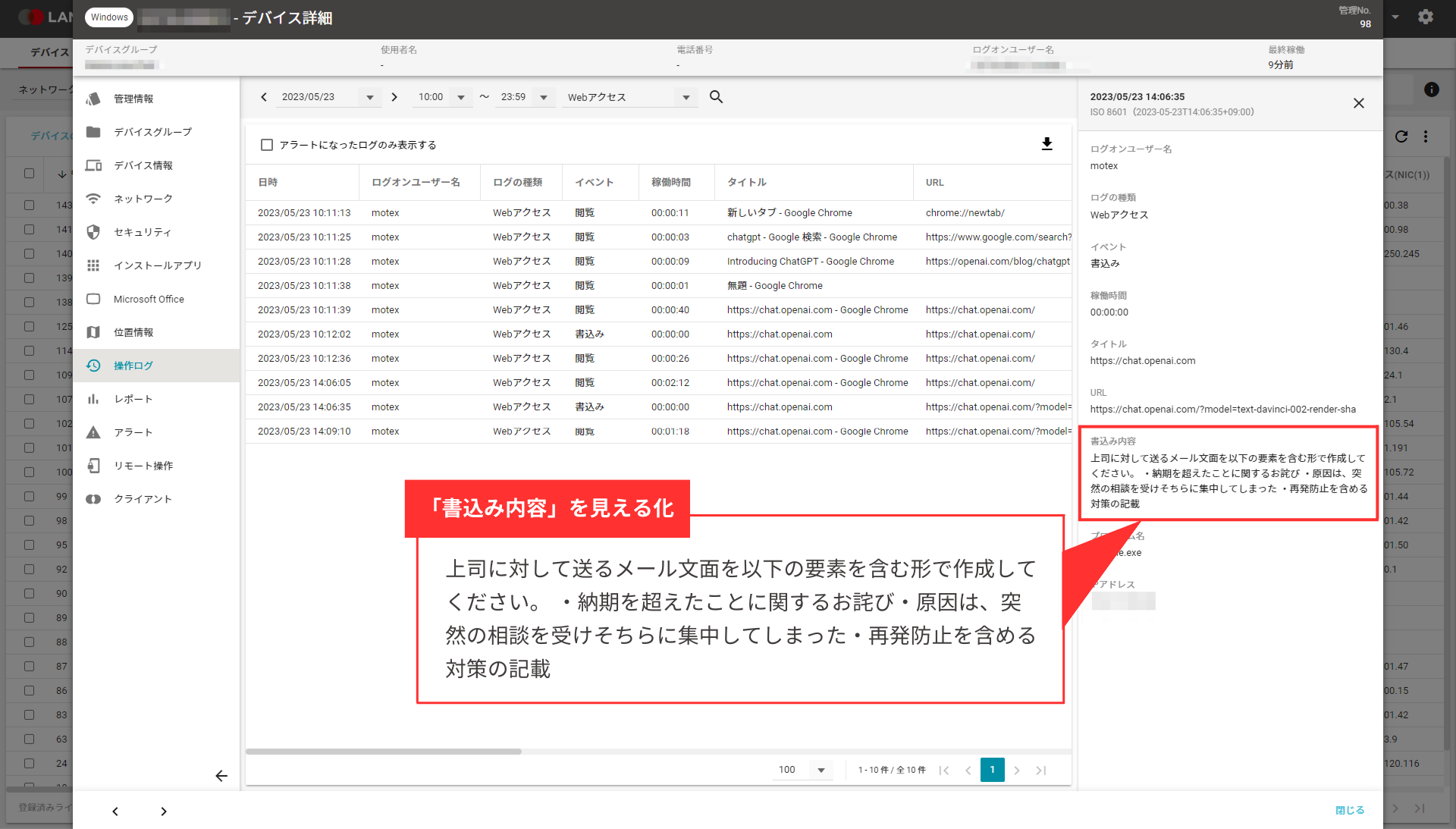

4.ChatGPTの会話をログで取得

4つ目の対策は、利用者がチャットボットと交わしたChatGPTでの対話履歴を「監査ログで取得」することです。対話をログで残すことで、先述した「ChatGPTへの機密情報の入力」や「ChatGPTの悪用(攻撃コードの作成、誹謗中傷のコンテンツを作成する等)」を、取り締まれるためです。

ChatGPT自体にも、不正使用を監視する際のため、新しい会話履歴が30日間保存される仕様が備わっています。ただし個々のアカウントから履歴を個別に確認しなければならないので、複数のChatGPTアカウントの会話ログを、一括で取得・閲覧できるツールがあるとさらに便利でしょう。

「LANSCOPE エンドポイントマネージャー クラウド版」では、従業員がChatGPTに入力した情報(=質問した内容)を、PC操作ログとして取得・把握できます。

ChatGPTやAI利用のセキュリティガイドラインも参考に

各GPTやAIサービスでは、公式サイトにて「利用規約」や「セキュリティ対策」等をまとめたガイドラインを掲載しています。ChatGPTを活用する際は、あらかじめ公式サイトが公開しているガイドラインを参考にし、違反行為やセキュリティリスクの高い行為を避けることが大切です。

OpenAIとBing AIのガイドラインについては、下記のURLから確認できます。

■OpenAIの規約

https://openai.com/policies/terms-of-use

https://openai.com/policies/usage-policies

■Bing AI(Bing スレッド エクスペリエンス)の規約

https://www.bing.com/new/termsofuse

また、各社が公開しているガイドラインをそのまま従業員に公開するのではなく、あくまで自社の現状に合わせたガイドラインを作成し、従業員に理解してもらうことが大切です。しかし、一からガイドラインを作成するのも骨が折れる仕事です。

MOTEXのソリューションを導入いただいているお客様からも、「ガイドラインを作成したいけど、どのように手を付けたら良いか分からない」といったご相談を度々頂きました。そこで弊社では「 AIサービス利用ガイドライン 」を作成し、お客様にご提供しています。ガイドラインの作成にお困りのお客様はぜひ参考にしてください。

“ChatGPT”の社内利用ルール、どう決める?

【AIサービス利用ガイドライン】を公開!

MOTEXが社内向けに作成したAIサービス利用ガイドラインをダウンロードできます。ChatGPT をはじめ、各種 AI サービスの業務利用ルール策定の参考に活用いただけます。

ChatGPTの利用状況の「見える化」なら「LANSCOPE エンドポイントマネージャークラウド版にお任せ

ChatGPTのガイドラインを従業員に公開後、さらに重要なのは「ガイドラインを守って利用してくれているか?」の把握です。ガイドラインを作成しても、それを守ってもらわなければセキュリティリスクの軽減には繋がりません。

弊社が提供するIT資産管理・MDM「LANSCOPE エンドポイントマネージャー」では、ChatGPTに書き込んだ内容(=質問した内容)を操作ログとして取得できます※。

LANSCOPE エンドポイントマネージャーでは「誰が」「いつ」「どの端末で」「どんな操作をしたか」といった端末の利用状況を記録・可視化できるため、組織における「情報漏洩対策」や「内部不正抑止策」などに活用いただけます。

ChatGPTの利用時間の集計だけでなく、ChatGPTへの質問内容も合わせて把握できるため、ガイドラインを守った運用ができていない場合に、従業員に改めてルールの遵守を呼びかけるなどのアクションを起こすきっかけにもなります。

※「エンドポイントマネージャー オンプレミス版」はGoogle Chrome、「クラウド版」はGoogle ChromeとMicrosoft Edge上で「https://chat.openai.com/」にアクセスし、書き込んだ内容を取得できます。尚、オンプレミス版・クラウド版ともに、Windows PCのみ対応しています。

まとめ

ChatGPTは、その利便性と画期的な機能から、世界中の企業よりビジネスへの活用を期待されています。しかし、セキュリティリスクの懸念という側面もあることから、組織は導入にあたり、セキュリティ体制の整備と従業員の意識向上に取り組む必要があります。

この記事のまとめ

- ChatGPTは、Web上のデータを収集・解析して最適な回答を提供する最新のAI言語処理であり、最新モデルのGPT-4は、 GPT-3.5と比較して処理性能が大幅に向上している

- ChatGPTのGPT-4は有料版(月額20$)で、Microsoft BingではGPT-4を搭載した「Bingチャット」は無料。

- 2023年現在ChatGPTのセキュリティリスクとして、機密情報や個人データの漏洩、誤った情報の提供や著作権問題、サイバー攻撃への悪用が挙げられる

- サイバー攻撃の一例として、フィッシング詐欺文書の生成、マルウェアや攻撃コードの生成、ChatGPTを装った偽サイトの公開などがある

- セキュリティリスクを軽減する対策として、ChatGPT利用にあたってのポリシー策定、機密データの入力禁止、生成データの正確性や著作権の確認、対話履歴のログ管理などが有効

社内のセキュリティポリシーの策定やデータの管理ルールを徹底するとともに、公式サイトのガイドラインにも目を通し、安全なChatGPTの運用体制を目指しましょう。

“ChatGPT”の社内利用ルール、どう決める?

【AIサービス利用ガイドライン】を公開!

MOTEXが社内向けに作成したAIサービス利用ガイドラインをダウンロードできます。ChatGPT をはじめ、各種 AI サービスの業務利用ルール策定の参考に活用いただけます。

おすすめ記事