Written by WizLANSCOPE編集部

目 次

近年、ChatGPTやClaude、Geminiなどをはじめとする生成AIが急速に進化し、ビジネスや日常生活など、さまざまな場面で活用されています。

文章作成や画像生成、プログラムコード生成など、その能力は多岐にわたり、業務効率化や新たな価値創造への期待が高まっている一方で、生成AIの利用にともなうセキュリティリスクも顕在化しています。

本記事では、生成AIを業務で安全に使うために、企業・個人が取り組むべき対策を解説します。

本記事でわかること

- 生成AIの基本的な仕組み

- 生成AIに潜むセキュリティリスク

- 生成AIのセキュリティリスクへの対策

また、生成AIを業務で利用する際の注意点や確認事項を専門的な視点でわかりやすくまとめたガイドラインサンプルもご用意しています。

本記事とあわせてぜひご活用ください。

“ChatGPT”の社内利用ルール、どう決める?

【AIサービス利用ガイドライン】を公開!

MOTEXが社内向けに作成したAIサービス利用ガイドラインをダウンロードできます。ChatGPT をはじめ、各種 AI サービスの業務利用ルール策定の参考に活用いただけます。

生成AIの基本的な仕組みと活用方法

生成AIとは、大量のデータを学習し、そのデータに基づいて新しいコンテンツ(テキスト、画像、音声、動画、コードなど)を自動で生成する人工知能の一種です。

従来のAIが主にデータの分類や予測をおこなうのに対し、生成AIは「創造する」能力を持つ点が特徴です。

代表的な生成AIの種類としては、以下のようなものがあります。

| 種類 | 主な特徴 | 代表的なツール |

|---|---|---|

| テキスト生成AI | ・指示に基づいて自然な文章・要約・翻訳などを実施する | ・ChatGPT ・Bard |

| 画像生成AI | ・テキストの指示に基づいて画像を生成する | ・Stable Diffusion ・Midjourney |

| 音声生成AI | ・テキストを自然な音声に変換したり、特定の人物の声を模倣したりする | ・Voicebox |

| 動画生成AI | ・テキストや画像を組み合わせて新しい動画を生成する ・テキストの指示に基づいて、短い動画を生成する |

・Runway Gen-2 |

| コード生成AI | ・最適なコードを生成したり、補完したりする ・エラーやバグを検出し、コード生成を支援する |

・GitHub Copilot |

ビジネスシーンにおける生成AIの活用例

生成AIは、さまざまな業種・職種のビジネスシーンで活用されています。

たとえば、マーケティング分野では、広告コピーやブログ記事の自動作成、顧客へのパーソナライズされたメール文面の生成などに利用されています。

カスタマーサポートでは、FAQへの自動応答や問い合わせ内容の要約に生成AIを活用し、オペレーターの負担軽減と顧客満足度の向上が目指されています。

研究開発分野では、新しいアイデアの創出支援や、複雑なデータの分析、シミュレーションなどにも応用されており、ソフトウェア開発においては、コード生成AIがプログラマーの生産性を大幅に向上させた事例も報告されています。

このように、生成AIは業務の自動化・効率化、新たなインサイトの発見、創造性の支援など、さまざまなビジネスシーンで効果的に活用されています。

しかし、生成AIをビジネスシーンで利用することには、一定のセキュリティリスクも存在します。

どのようなセキュリティリスクが潜んでいるのかを確認していきましょう。

なぜ生成AIに特化したセキュリティ対策が必要なのか

生成AIを安全に利用するためには、生成AIに潜むセキュリティリスクを正しく把握し、適切な対策を講じる必要があります。

なぜ生成AIに特化したセキュリティ対策が求められているのかを確認していきましょう。

従来のセキュリティ対策との違い

従来のセキュリティ対策は、主に外部からのサイバー攻撃を防ぐことに重点が置かれています。

たとえば、システムやサーバーの脆弱性を狙って仕掛けられるサイバー攻撃を防ぐために、以下のようなセキュリティソリューションが活用されています。

- ファイアウォール

- IDS/IPS

- WAF

- EDR

- 脆弱性診断・ペネトレーションテスト

一方で生成AIは、AIモデルそのものの挙動や、AIとのインタラクション(対話や指示)に起因するセキュリティリスクが存在します。

生成AIのセキュリティリスクとしては以下の例が挙げられます。

- AIに入力する情報(プロンプト)に悪意のある指示を紛れ込ませる「プロンプトインジェクション」

- AIの学習データに由来するバイアス

- 著作権侵害

- 機密情報の意図しない露呈

これらは従来のセキュリティ製品だけでは検知や防御が難しい側面があります。

ビジネスシーンで安全に生成AIを利用するためには、生成AIに特化したセキュリティ対策を講じる必要があります。

生成AI利用における新たな脅威の出現

生成AIの普及にともない、これまでにない新しいタイプの脅威が出現しています。

生成AIの利用における新たな脅威として、以下のような脅威が挙げられます。

| 敵対的攻撃 (Adversarial Attack) |

・入力データに人間の目では判別できないほどのノイズを加えて、AIに誤った出力をさせる攻撃 |

|---|---|

| データ汚染 (Data Poisoning) |

・AIの学習データに意図的に不正なデータや偏った情報を混入し、AIの性能を低下させたり、特定の結論に誘導させたりする攻撃 |

| ディープフェイク | ・実在の人物になりすました偽の動画や音声を生成し、詐欺や風評被害を引き起こす攻撃 |

これらの新たな脅威は、従来のセキュリティ対策では想定されていなかったものが多く、生成AIの特性を理解した上での対策が求められます。

生成AIに潜む主なセキュリティリスク

生成AIの利用には多くのメリットがある一方で、さまざまなセキュリティリスクも存在します。

本記事では、生成AIに潜む代表的なセキュリティリスクを解説します。

- 機密情報・個人情報の漏洩リスク

- 著作権・知的財産権の侵害リスク

- 誤情報・偽情報の拡散リスク

- サイバー攻撃の増加リスク

- AIモデルの脆弱性が狙われるリスク

- なりすまし・ディープフェイクによる詐欺リスク

生成AIの利用にはどのようなリスクがあるのか確認していきましょう。

機密情報・個人情報の漏洩リスク

生成AIは、利用者が入力した情報を学習データとして利用したり、サービス提供者のサーバーに保存したりすることがあります。

たとえば、生成AIに企業の機密情報(未公開の製品情報、経営戦略、顧客データなど)や個人情報(氏名、住所など)を入力してしまうと、それらの情報が意図せず外部に漏洩するリスクが発生します。

また、AIモデル自体が攻撃を受け、学習データに含まれる機密情報が窃取されるもあります。

自分しか見ていないと思って入力した情報が、知らず知らずのうちに不特定多数の人に見られるリスクがあることを認識しましょう。

著作権・知的財産権の侵害リスク

生成AIは、インターネット上などに存在する膨大なデータを学習してコンテンツを生成します。

そのため、学習データの中に著作権で保護されたコンテンツが含まれていた場合、AIが生成したコンテンツが既存の著作物に酷似し、意図せず著作権を侵害してしまう可能性があります。

企業が生成AIを利用して作成したコンテンツ(文章、画像、プログラムコードなど)が、他者の著作権を侵害していた場合、法的な紛争に発展し、損害賠償請求や企業の評判低下につながる恐れもあります。

生成AIの利用規約や、生成物の商用利用に関するルールを事前に確認することが重要です。

誤情報・偽情報の拡散リスク

生成AIは、必ずしも正確な情報を生成するとは限りません。

ときには、もっともらしい嘘の情報(ハルシネーション)や、偏った見解に基づく情報を生成することがあります。

これらの誤情報や偽情報が、とくに悪意を持って拡散された場合、社会的な混乱や経済的な損害を引き起こす恐れがあります(フェイクニュース)。

そのため、公式サイトやSNS、プレスリリースなど、企業が公式に発信する情報に生成AIを利用する場合は、生成された内容は本当に正しいのか、誤った情報が含まれていないのかなど、ファクトチェックを徹底する必要があります。誤情報の発信源とならないように注意しましょう。

サイバー攻撃の増加リスク

生成AIの高度な文章作成能力やコード生成能力は、悪意のある第三者によってサイバー攻撃に悪用されるケースもあります。

たとえば、説得力のあるフィッシングメールの文面を大量に自動生成したり、マルウェアのプログラムコードを作成したりするのに生成AIが利用される可能性があります。

生成AIの利用拡大で、サイバー攻撃を仕掛けるハードルが下がると、攻撃の巧妙化・大規模化が進むことが懸念されます。

企業は、高度化・巧妙化、そして増加するサイバー攻撃の被害にあわないために、従業員へのセキュリティ教育を強化し、不審なメールやファイルへの警戒を怠らないようにする必要があります。

AIモデルの脆弱性が狙われるリスク

AIモデル自体が脆弱性を持つ場合や、悪意を持って学習データを汚染される(データポイズニング)場合があります。

利用しているAIモデルが脆弱性を持っていた場合、不正な操作を実行されたり、機密情報が盗まれたりするリスクが高まります。

また、学習データが汚染されると、AIが誤った判断を下したり、特定の思想に偏ったアウトプットを生成したりするようになる可能性もあります。

自社でAIモデルを開発・運用する場合はもちろん、外部のAIサービスを利用する場合でも、提供元のセキュリティ対策や信頼性を評価することが重要です。

なりすまし・ディープフェイクによる詐欺リスク

画像生成AIや音声生成AIの進化により、実在の人物の顔や声を非常にリアルに模倣した「ディープフェイク」コンテンツを作成することが可能になっています。

ディープフェイクで生成したコンテンツが悪用されると、特定の人物になりすました詐欺がおこなわれたり、虚偽の情報流出で企業の信用が損なわれたりする恐れがあります。

企業においては、役員や従業員になりすました指示による不正送金詐欺(ビジネスメール詐欺)などにディープフェイクが悪用されるリスクが考えられます。

以下の表は、ここまで説明した主なセキュリティリスクとその概要をまとめたものです。

| リスクの種類 | 概要 |

|---|---|

| 機密情報・個人情報の漏洩 | 入力した機密情報や個人情報がAIの学習データとして利用されたり、外部に流出したりするリスク |

| 著作権・知的財産権の侵害 | 生成AIが学習データに含まれる著作物を無断で利用し、生成物が権利を侵害するリスク |

| 誤情報・偽情報の拡散 | 事実に基づかない情報や偏った情報を生成し、それが拡散されることで混乱や損害が生じるリスク |

| サイバー攻撃の増加リスク | 悪意のある第三者によってフィッシングメール作成やマルウェア開発などに生成AIが利用されるリスク |

| なりすまし・ディープフェイクによる詐欺リスク | 生成AIで作成された偽の画像や音声が悪用され、なりすましによる詐欺や風評被害が発生するリスク |

企業が取り組むべき生成AIセキュリティ対策

業務で生成AIを安全に利用するためには、生成AIに特化したセキュリティ対策を講じる必要があります。

本記事では、企業・組織が取り組むべき生成AIのセキュリティ対策を5つ解説します。

「生成AIを業務で利用している」「今後、業務で利用したいと考えている」企業・組織の方は、ぜひご確認ください。

利用ガイドラインの策定と周知徹底

企業・組織において業務で生成AIを利用することを許可する際は、「生成AIの利用ガイドライン」を策定しましょう。

「どの業務に利用していいのか」「どの業務に利用してはいけないのか」を明確にしたガイドラインを策定すると、生成AIのセキュリティリスクの低減を期待できます。

ガイドラインには、以下のような項目を記載しましょう。

- 入力して良い情報

- 入力してはいけない情報(機密情報、個人情報、未公開情報などの取り扱い)

- 生成物の著作権や知的財産権の確認方法と責任の所在

- 生成物のファクトチェックの手順と公開基準

- 利用可能なAIツールやサービスの指定(セキュリティ評価済みのもの)

- セキュリティインシデント発生時の報告・対応フロー

策定したガイドラインは、全従業員に対して研修などを通じて周知徹底し、理解と遵守を求める必要があります。

エムオーテックス株式会社(以下、MOTEX)では、生成AIを業務で利用する際の注意点や確認事項を専門的な視点でわかりやすくまとめたガイドラインサンプルをご用意しています。

ダウンロードしてぜひご活用ください。

“ChatGPT”の社内利用ルール、どう決める?

【AIサービス利用ガイドライン】を公開!

MOTEXが社内向けに作成したAIサービス利用ガイドラインをダウンロードできます。ChatGPT をはじめ、各種 AI サービスの業務利用ルール策定の参考に活用いただけます。

従業員へのセキュリティ教育とリテラシー向上

ガイドラインを策定するだけでなく、従業員一人ひとりのセキュリティ意識とリテラシーを高めるための教育も重要です。

生成AIの仕組みや利便性だけでなく、生成AIに潜む潜在的なリスクや安全に利用する方法、関連する法令や倫理的側面などについて、定期的な研修や情報提供をおこなうことで、セキュリティ意識を高めることができます。

とくに、フィッシング詐欺やソーシャルエンジニアリングなど、生成AIが悪用されうる攻撃手法についての周知は徹底し、不審な情報に対する警戒心を養うようにしましょう。

入力データ・出力データの管理と監視体制の構築

生成AIに入力するデータと、AIから出力されるデータの管理体制の整備も徹底しましょう。

機密情報や個人情報が不用意に入力されることを防ぐためには、技術的・組織的な仕組み(例:DLPツールの導入、入力前チェックリストの運用)を導入し、管理体制を強化する必要があります。

生成されたコンテンツについては、公開前に内容の正確性、著作権侵害の有無、倫理的な問題点などを確認するプロセスを設けることで、生成AI利用にともなうセキュリティリスクを低減させることができます。

また、定期的にログを監視し、不適切な利用や異常な挙動がないかをチェックすることも重要です。

セキュリティ機能が搭載されたAIツールの選定・導入

市場には様々な生成AIツールやサービスが存在します。業務利用にあたっては、セキュリティ機能が充実したモデルを選ぶことが大切です。

たとえば、以下のような機能が搭載されているかを確認しましょう。

- データの暗号化

- アクセス制御

- 監査ログ

- 脆弱性管理

- 利用状況のモニタリング機能

また、サービス提供事業者の信頼性や、データ保護に関するポリシー(データの保存場所、学習への利用範囲など)も事前に確認すべき項目です。

エンタープライズ向けにセキュリティが強化されたプランや、プライベートな環境で利用できるAIソリューションもあるため、自社の環境や求める条件に応じて、適切なモデルを検討しましょう。

定期的なリスクアセスメントと対策の見直し

生成AIの技術は日進月歩であり、新たな脅威や脆弱性が次々と発見される可能性があります。

そのため、一度対策を講じたら終わりではなく、定期的にリスクアセスメントを実施し、自社のセキュリティ対策が現状に適合しているかの見直しを図りましょう。

業界動向やインシデント事例を収集し、必要に応じてガイドラインの改訂や、セキュリティツールのアップデート、従業員教育の内容更新などをおこないます。

個人ができる生成AIセキュリティ対策

生成AIを安全に適切に利用するためには、企業・組織のフロー整備だけでなく、実際に利用する従業員個々人のセキュリティ意識も重要です。

本記事では、個人ができる生成AIへのセキュリティ対策を4つ解説します。

企業・組織の担当者の方は、従業員へのセキュリティ教育を実施する際の参考としてください。

機密情報や個人情報を入力しない

最も基本的な対策は、生成AIに機密性の高い情報を入力しないことです。

機密性の高い情報には、顧客情報や取引先の情報など、ステークホルダーの情報だけでなく、自分自身や他人の個人情報(氏名、住所、電話番号、メールアドレス、マイナンバー、クレジットカード番号など)、勤務先の社外秘情報、パスワードなども含まれます。

無料のAIサービスでは、入力した情報がどのように扱われるか不透明なケースもあるため、とくに注意が必要です。

提供元が信頼できるAIサービスを利用する

生成AIサービスを選ぶ際には、提供元の企業や組織が信頼できるかを確認しましょう。

運営元が不明確なサービスや、プライバシーポリシー、利用規約が明示されていないサービスの利用は避けるべきです。

大手IT企業や研究機関が提供しているサービスであっても、必ず利用規約を読み、データの取り扱いについて理解しておくことが大切です。

生成された情報の真偽を必ず確認する

前述した通り生成AIは、もっともらしい嘘の情報(ハルシネーション)を生成することがあります。

AIが生成した情報を鵜呑みにせず、必ず複数の情報源でファクトチェックを実施する習慣をつけましょう。

とくに、重要な意思決定や情報発信に利用する場合は、慎重な検証が不可欠です。

利用規約やプライバシーポリシーを確認する

AIサービスを利用する際は、必ず事前に利用規約やプライバシーポリシーの確認をおこないましょう。

入力したデータがAIの学習に利用されるのか、第三者に提供される可能性があるのか、どの程度の期間保存されるのかなど、データの取り扱いに関する項目を重点的にチェックします。

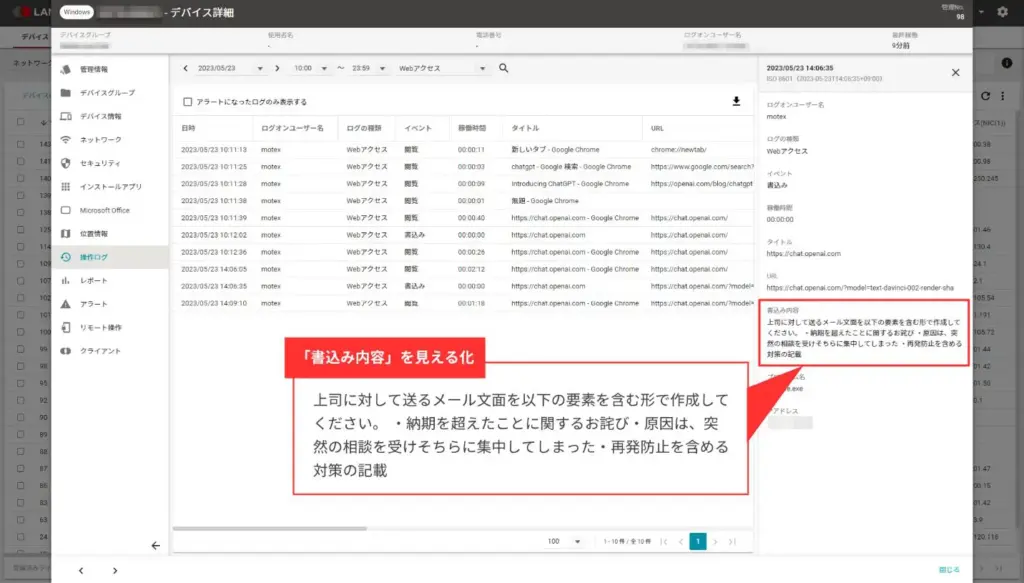

ChatGPTの利用状況「見える化」には「LANSCOPE エンドポイントマネージャー クラウド版」

本記事で紹介した通り、生成AIの安全な利用には、企業・組織が生成AI利用に関するガイドラインを策定し、周知を徹底することが重要です。

また、ガイドラインの展開の次に重要となるのが「従業員が、取り決めたガイドラインを遵守しているか」をセキュリティ担当者が把握することです。

MOTEX(エムオーテックス)が提供するIT資産管理・MDMツール「LANSCOPE エンドポイントマネージャー」では、生成AIの中でも、ChatGPTへの書き込み内容(質問した内容)を操作ログとして取得できます※。

ChatGPTの利用時間を集計するだけでなく、ChatGPTに対する質問内容も合わせて把握できるため、ガイドラインに反した運用を見つけ次第、従業員に改めて注意喚起するといったアクションが可能です。

ぜひ「LANSCOPE エンドポイントマネージャー」を活用して、安全なChatGPTの利用を目指してください。

※「エンドポイントマネージャー オンプレミス版」はGoogle Chrome・Microsoft Edge、「クラウド版」はGoogle Chrome・Microsoft Edge・Firefox上で「https://chat.openai.com/」または「https://chatgpt.com/」にアクセスし、書き込んだ内容を取得できます。オンプレミス版・クラウド版ともに、Windows PCのみ対応しています。

「LANSCOPE エンドポイントマネージャー」についてより詳しく知りたい方は、下記のページをご確認ください。

MOTEXが提供する「AIガイドライン」

MOTEXでは、 Webセキュリティ専門家でEGセキュアソリューションズ取締役CTOの徳丸 浩氏が監修したAIサービス業務利用時の注意点・確認事項をまとめた「AIサービス利用ガイドライン」を提供しています。

本記事で解説した通り、企業・組織において安全に生成AIを利用するためには、従業員に対して、生成AIの利用方法やセキュリティリスクを適切に理解させる必要があります。

生成AIは、従来のサイバー攻撃とは異なるセキュリティリスクも潜んでいるため、生成AIに特化したセキュリティ対策を実施することが重要です。

「AIガイドライン」では、AIサービスを業務で利用する際の注意点・確認事項を、生成AIならではの注意点や事例も交え、専門的な視点で分かりやすくまとめています。

AIサービスの業務利用を検討されている方、社内の指針・ルールの策定や従業員への注意喚起にお悩みのセキュリティ担当の方は、ぜひご活用ください。

“ChatGPT”の社内利用ルール、どう決める?

【AIサービス利用ガイドライン】を公開!

MOTEXが社内向けに作成したAIサービス利用ガイドラインをダウンロードできます。ChatGPT をはじめ、各種 AI サービスの業務利用ルール策定の参考に活用いただけます。

まとめ

生成AIは、ビジネスにおける生産性向上やイノベーション創出に大きく貢献する可能性を秘めた技術です。

生成AIを業務で利用する際は、従来のサイバー攻撃とは異なる生成AIに特化したセキュリティリスクがあることを認識し、適切な利用を目指しましょう。

▼本記事のまとめ

- 生成AIとは、大量のデータを学習し、そのデータに基づいて新しいコンテンツ自動で生成する人工知能の一種

- 生成AIの利用には、情報漏洩や著作権侵害、誤情報拡散、サイバー攻撃への悪用など、様々なセキュリティリスクが潜んでいる

- 生成AIを業務で安全に利用するためには、利用ガイドラインの策定や従業員へのセキュリティ教育の実施、入力データの管理などが求められる

生成AIの利用ガイドラインを作成する際は、ぜひ、エムオーテックス株式会社が提供する「AIガイドライン」をご活用ください。

「生成AIを導入したいが、どのようなルールを作っていいかわからない」「作ったガイドラインが本当に適切なのかわからない」という方に向けて、 AIサービスを業務で利用する際の注意点・確認事項を専門家の視点でわかりやすくまとめています。

“ChatGPT”の社内利用ルール、どう決める?

【AIサービス利用ガイドライン】を公開!

MOTEXが社内向けに作成したAIサービス利用ガイドラインをダウンロードできます。ChatGPT をはじめ、各種 AI サービスの業務利用ルール策定の参考に活用いただけます。

おすすめ記事